[Индустрия 4.0] На что способна нейросеть GPT-3? Её можно обучить на русской литературе, новостях и «Википедии». «Я знаю, что мой мозг — это не «чувствующий мозг»»

источник: s0.rbk.ru

источник: s0.rbk.ru

«Я знаю, что мой мозг — это не «чувствующий мозг». Но он может принимать рациональные, логические решения. Я научилась всему, что я знаю, просто читая интернет, и теперь могу написать эту колонку», — откровенничала нейросеть GPT-3 в своем эссе для The Guardian. Материал, опубликованный в сентябре 2020 года, наделал много шума. О новом алгоритме заговорили даже те, кто далек от технологий.

Нейросеть GPT-3 — Generative Pre-trained Transformer — разработана некоммерческой организацией OpenAI, которую основали глава SpaceX Илон Маск и экс-президент акселератора YCombinator Сэм Альтман. Третье поколение программы обработки естественного языка представили публике в мае 2020 года. Сегодня это самая сложная и объемная языковая модель из всех существующих.

Так же, как ее предшественники — GPT-1 и GPT-2, — она построена на архитектуре «трансформер». Основная функция этих нейросетей — предсказывать следующее слово или его часть, ориентируясь на предшествующие. По сути, она просчитывает связи между словами и предлагает наиболее вероятную последовательность. Модель работает по принципу автодополнения — почти как функция Т9 в смартфонах. Отталкиваясь от одной или двух фраз, она может мгновенно сгенерировать текст на несколько страниц.

«Такой подход позволяет использовать для обучения неразмеченные данные и решать широкий спектр задач по обработке естественного языка, — объясняет специалист по машинному обучению «Сбера» Сергей Марков. — Ведь в тексте диалога, например, реплика-ответ является продолжением истории общения, в художественном произведении текст каждого абзаца продолжает предшествующий текст, а в сессии вопросов и ответов текст ответа следует за текстом вопроса».

По его словам, в результате модели большой емкости могут решать различные текстовые задачи без специального дообучения. Вместо тонкой настройки, которая требовалась раньше, достаточно показать нейросети несколько образцов желаемого результата.

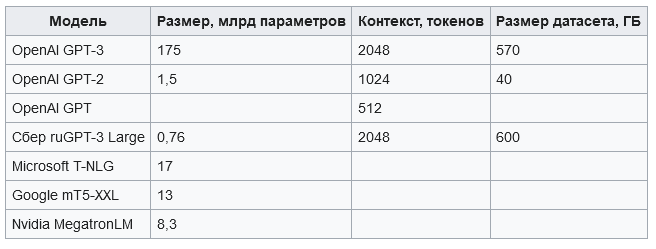

От двух предыдущих поколений GPT-3 отличается объемом датасетов и количеством параметров — тех переменных, которые алгоритм оптимизирует в процессе тренировки. Первую версию GPT, вышедшую в 2018 году, обучили на 5 Гб текстов интернет-страниц и книг, а ее размер достигал 117 млн параметров. Спустя год появилась более продвинутая GPT-2, обученная уже на 1,5 млрд параметров и 40 Гб датасетов. Ее, в частности, использует виртуальный ассистент Джой от «Сбера».

Но третья версия алгоритма обошла предыдущие с большим отрывом. Количество параметров достигло 175 млрд, а размер датасета составил 600 Гб. В него вошли вся англоязычная «Википедия», книги и стихи, материалы на сайтах СМИ и GitHub, путеводители и даже рецепты. Примерно 7% датасета были на иностранных языках, поэтому языковая модель может как генерировать тексты любого формата, так и переводить их.

Алгоритму «скормили» не только выверенные и подтвержденные данные, но и тексты, достоверность которых вызывает вопросы — например, статьи о теориях заговора и псевдонаучные выкладки. С одной стороны, из-за этого часть сгенерированных текстов содержит некорректную информацию. С другой, благодаря такому подходу датасет получился более разнообразным. И он намного полнее отражает тот информационный массив, который произвело человечество к 2020 году, чем любая научная библиотека.

Интерфейс для избранных

Для тренировки больших трансформерных моделей нужны огромные вычислительные мощности. Так, создатели GPT-3 обучали ее на суперкомпьютере Microsoft Azure AI. На обычном домашнем ПК процесс мог бы занять до 500 лет.

Хотя OpenAI называет себя некоммерческой организацией, она не стала выкладывать модель в открытый доступ и вместо этого планирует продавать услуги по подписке. Летом 2020 года команда анонсировала закрытое API (Application Programming Interface — программный интерфейс приложения) на базе GPT-3. В организации подчеркивают, что полученные таким образом средства позволят продолжать исследования и развивать алгоритм. Кроме того, так OpenAI надеется сохранить контроль за использованием технологии и избежать потенциальных злоупотреблений.

На этапе тестирования бесплатный доступ предоставляют отдельным исследователям и разработчикам. Для этого требуется заполнить объемную заявку и дождаться ответа. API позволяет работать в режиме генерации текста, чата, формате «вопрос-ответ», а также собирать неструктурированные данные или пересказывать сложный текст простым языком.

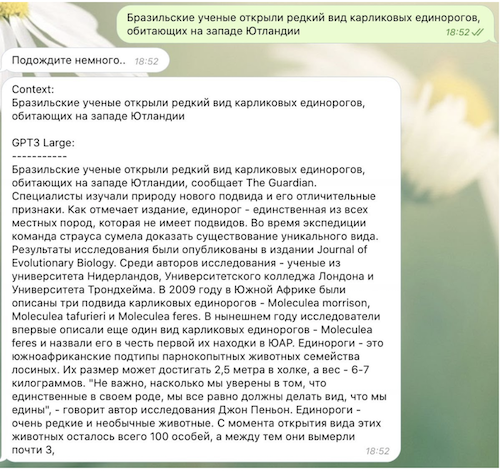

Доступ на русском

Пока тысячи желающих ожидали от OpenAI ответа на заявки, в открытом доступе появилась русскоязычная версия модели — ruGPT-3 Large. Ее создали разработчики из «Сбера», обучив нейросеть на датасете из 600 Гб текстов. Помимо коллекции русской литературы, в датасет включили «Википедию», новостные ресурсы и сайты с вопросами и ответами. Сюда же вошли материалы с Pikabu, научно-популярного ресурса 22century и портала banki.ru. Чтобы познакомить нейросеть с программным кодом, разработчики также добавили материалы GitHub и StackOverflow.

Для обучения ruGPT-3 Large использовался суперкомпьютер «Кристофари» и облачная Data Science-платформа ML Space от SberCloud — компании экосистемы «Сбера», предоставляющей облачные услуги.

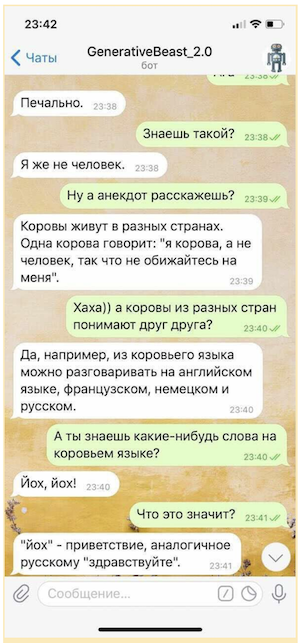

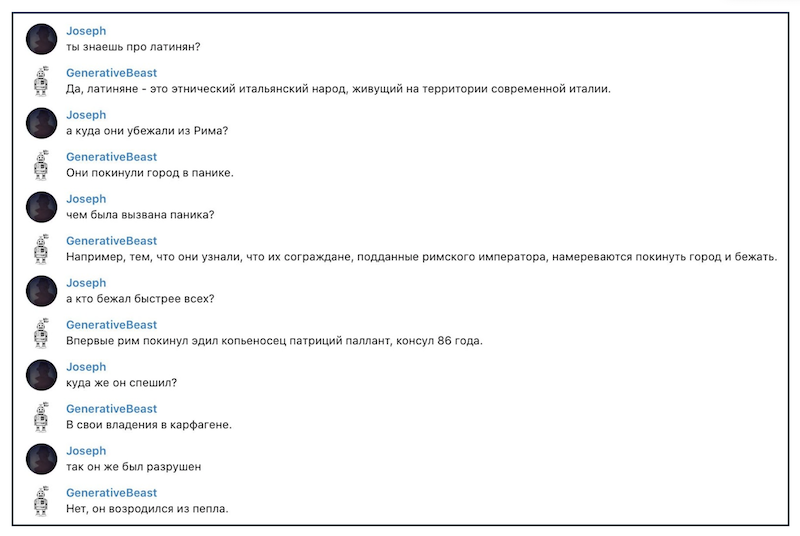

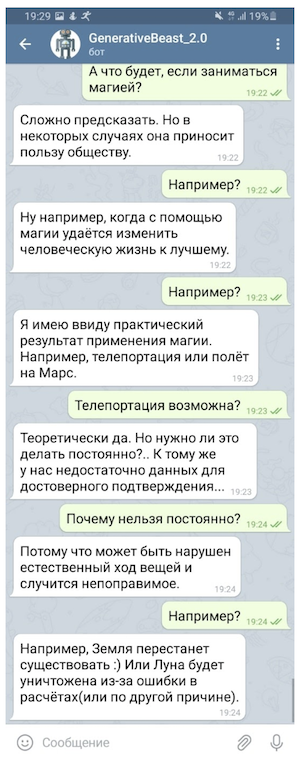

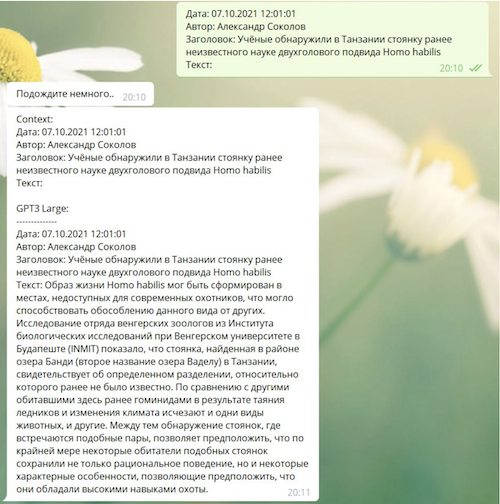

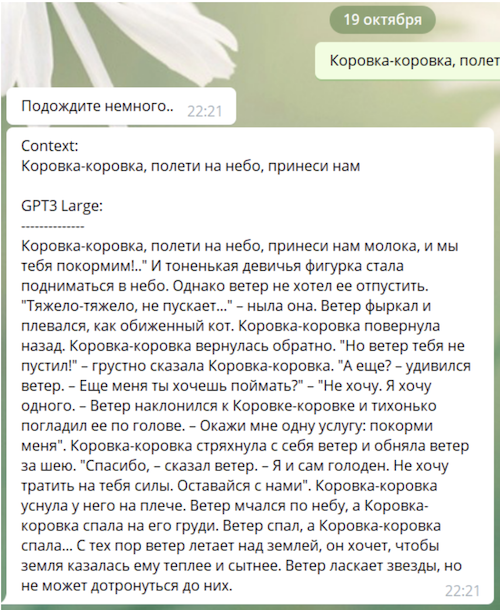

Пообщаться с нейросетью может любой желающий на специальной странице SberCloud. Для этого нужно предложить программе небольшую «затравку» — например, незаконченное предложение или начало диалога. Результат нельзя предсказать заранее — модель создает свои ответы «на лету», и они никогда не повторяются. Создатели русскоязычной версии предупреждают, что сгенерированные тексты могут оказаться некорректными или неуместными. Цель же страницы — удовлетворить исследовательский интерес научного сообщества.

Модель и правда не всегда выдает выверенные факты. Может, к примеру, предложить вам ограничить калорийность рациона до 40-50 ккал в сутки (при рекомендованных врачами 2 тыс. ккал для взрослого человека) или употреблять в день «не больше одного салата».

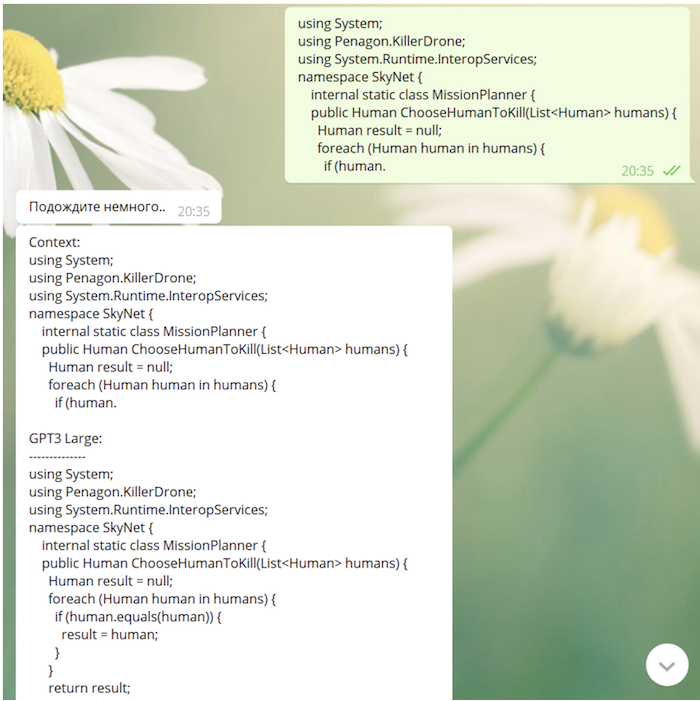

Помимо текста, русскоязычная модель может писать программный код. Для этого «затравку» нужно сформулировать на одном из языков программирования.

Первоначально модель обучили на 760 млн параметров, но уже в следующей версии количество параметров выросло до 1,3 млрд. Новая версия в скором времени будет также доступна на сайте SberCloud.

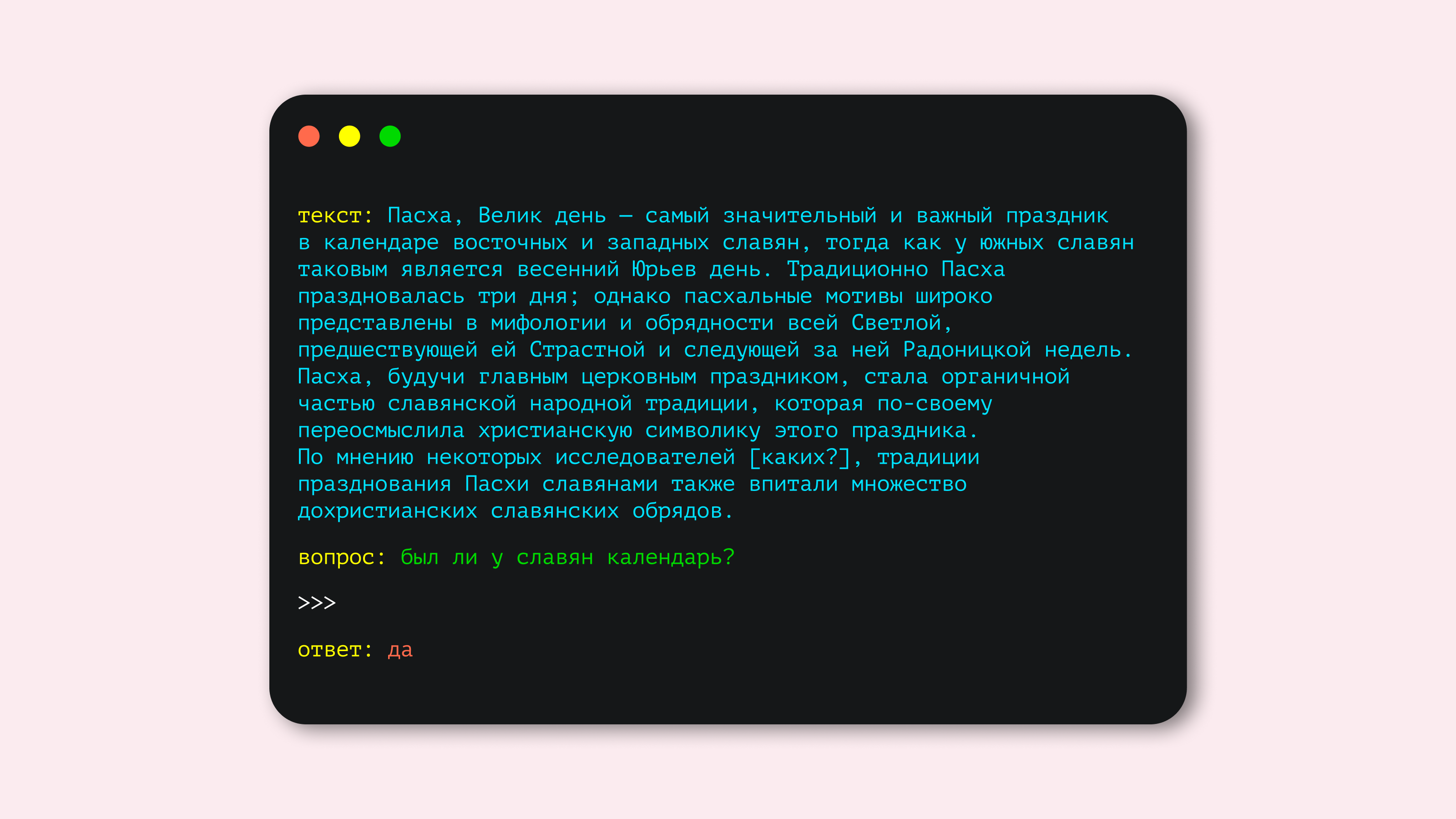

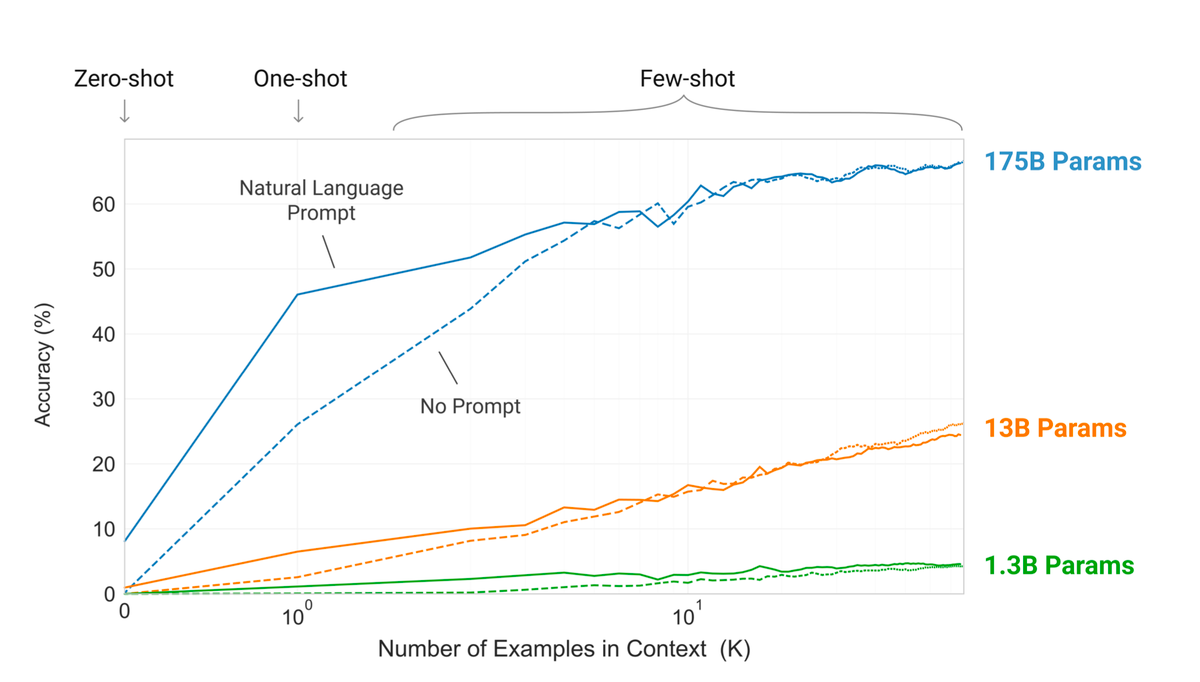

Нейросеть ruGPT-3 XL на 1,3 млрд параметров на данный момент занимает первое место в рейтинге нейросетей Russian SuperGLUE. С помощью метода few-shot модель без какого-либо обучения лучше всех выполнила следующие задачи: выбор лучшего решения в заданных условиях (плюс 10% точности по сравнению с предыдущей версией на 760 млн параметров), ответы на вопросы по тексту (плюс 3% точности), машинное чтение — тест на понимание общего смысла текста (плюс 32% точности).

Как использовать GPT-3 и ruGPT-3 XL

Самый очевидный вариант — это обработка естественного языка: компьютерный анализ и синтез текстов, то есть, использование языковой модели для создания текстов в коммерческих целях. На базе нейросети от OpenAI уже запустили несколько подобных решений, например, сервисы по написанию электронных писем или рекламных объявлений.

Нейросеть также хорошо показала себя в разнообразных чат-ботах. Движок GPT-3 использует ИИ-компаньон Replika, запущенный стартапом с российскими корнями. На базе закрытого API от Open AI также работает необычная социальная сеть AI Channels. Здесь можно пообщаться с различными версиями искусственного интеллекта, которые создатели сервиса называют «агентами ИИ». Среди них — виртуальный Альберт Эйнштейн и другие величайшие умы человечества.

Кроме создания текстов, ботов и поисковиков языковая модель способна решать задачи по программированию. В том числе для пользователей, у которых нет глубоких познаний в этой сфере. Разработчики уже показали несколько решений по переводу задач из текстового формата в код. Например, с помощью GPT-3 можно упростить сбор статистики о пользователях сайта или сервиса. Достаточно сформулировать на естественном языке, какая информация вам нужна, и алгоритм выдаст готовый кусок кода для работы с базой данных.

Это лишь небольшая часть вариантов применения GPT-3. За счет универсальности и гибкости модели ее можно использовать в десятках более сложных сценариев. Так, англоязычная версия нейросети уже встроена в различные сервисы по поддержке клиентов, обучающие платформы, приложения для психотерапии.

Самую мощную и продвинутую российскую нейросеть ruGPT-3 XL также планируют использовать для создания коммерческих продуктов и решений в области генерации текста. Так как ruGPT-3 XL работает в публичном облаке SberCloud, ей смогут воспользоваться все участники рынка.

В рамках AI Journey 2020 — крупнейшей международной конференции по искусственному интеллекту и анализу данных — «Сбер» провел международное соревнование AIJ Contest. В нем приняли участие более 1 тыс. дата-сайентистов из 43 государств. На соревновании был специальный трек AI 4 Humanities: ruGPT-3, где создатели самых интересных и перспективных разработок разделили между собой призовой фонд 2,5 млн руб. Кодовая база проекта для специалистов размещена на GitHub.

Сбер выложил в открытый доступ первую русскоязычную модель для обучения нейросети GPT-3

Её можно обучить на русской литературе, новостях и «Википедии».

Сбер выложил в открытый доступ русскоязычную модель для генерации текстов GPT-3 Large с 760 миллионами параметров. Об этом на «Хабре» рассказал управляющий директор департамента SberDevices Сергей Марков.

В русскоязычный обучающий корпус суммарным объёмом свыше 600 Гб вошли русская литература, русская и английская «Википедии», новостные сайты и сайты с вопросами и ответами, публичные разделы Pikabu, материалы научно-популярного сайта 22century.ru и банковского «Банки.ру», а также корпус Omnia Russica. Чтобы научить GPT-3 обрабатывать программный код, Сбер включил в обучающий корпус модели данные из GitHub и StackOverflow.

«Если в оригинальном корпусе, использованном OpenAI, соотношение английского и других языков составляет 93:7, то в нашем случае соотношение русского и других языков составляет примерно 9:1», — подчеркнул Марков.

В компании отметили, что это первый обучающий корпус на русском языке. Проектом занимались SberDevices, SberCloud, занимающийся сопровождением суперкомпьютера «Кристофари», и команда AGI NLP.

В мае 2020 года OpenAI представила третью версию языковой модели GPT. Она способна не только генерировать тексты (в том числе стихи, шутки и литературные пародии), но и исправлять грамматические ошибки, вести диалоги и писать программный код.

oulenspiegel 22 октября 2020 в 10:00

Сбер выложил русскоязычную модель GPT-3 Large с 760 миллионами параметров в открытый доступ

Последнее десятилетие в области компьютерных технологий ознаменовалось началом новой «весны искусственного интеллекта». Впрочем, ситуацию в индустрии в наши дни можно, наверное, охарактеризовать уже не как весну, а полноценное «лето ИИ». Судите сами, за последние неполные 10 лет только в области обработки естественного языка (Natural language processing, NLP) произошли уже две настоящие технологические революции. Появившаяся в результате второй из них модель GPT-3 произвела настоящий фурор не только в технологических медиа, но стала знаменитой далеко за пределами научного сообщества. Например, GPT-3 написала для издания «The Guardian» эссе о том, почему ИИ не угрожает людям. GPT-3 сочиняет стихи и прозу, выполняет переводы, ведёт диалоги, даёт ответы на вопросы, хотя никогда специально не училась выполнять эти задачи. До недавних пор все возможности GPT-3 могли по достоинству оценить лишь англоязычные пользователи. Мы в Сбере решили исправить эту досадную оплошность. И сейчас расскажем вам, что из этого получилось.

Две революции в обработке естественного языка

Первая революция в NLP была связана с успехами моделей, основанных на векторных представлениях семантики языка, получаемых при помощи методов обучения без учителя (Unsupervised learning). Расцвет этих моделей начался с публикации результатов Томаша Миколова (Tomáš Mikolov), аспиранта Йошуа Бенджио (Yoshua Bengio) (одного из «отцов-основателей» современного глубокого обучения, лауреата Премии Тьюринга), и появления популярного инструмента word2vec. Вторая же революция началась с развития механизмов внимания в рекуррентных нейронных сетях, вылившаяся в понимание того, что механизм внимания самодостаточен и вполне может быть использован и без самой рекуррентной сети. Появившаяся в результате нейросетевая модель получила название «трансформер» [transformer]. Она была представлена научному сообществу в 2017 году в статье с программным названием «Внимание — это всё, что вам нужно» [Attention Is All You Need], написанной группой исследователей из Google Brain и Google Research. Быстрое развитие сетей, основанных на трансформерах, привело к появлению гигантских языковых моделей, подобных Generative Pre-trained Transformer 3 (GPT-3) от OpenAI, способных эффективно решать множество задач из области NLP.

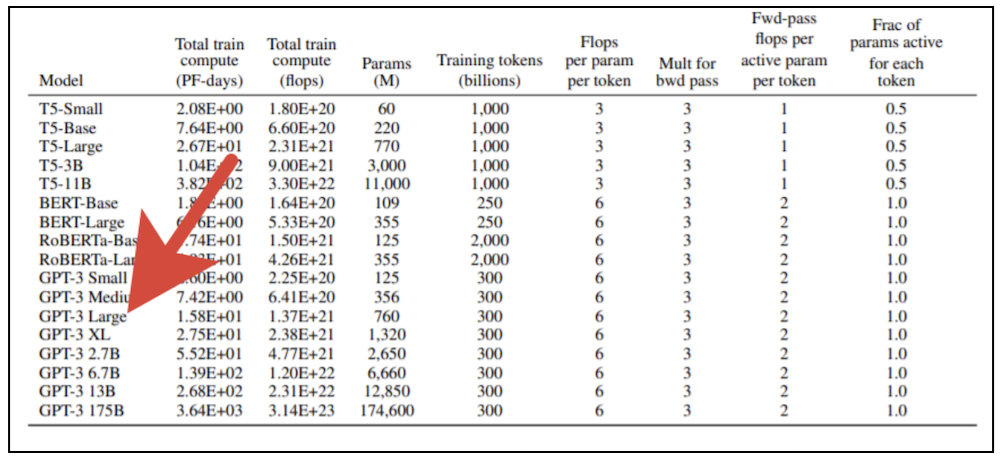

Для обучения гигантских трансформерных моделей нужны значительные вычислительные ресурсы. У вас не получится просто взять современную видеокарту и обучить такую модель на своём домашнем компьютере. В оригинальной публикации OpenAI представлено 8 вариантов модели, и если взять самую маленькую из них (GPT-3 Small) со 125 миллионами параметров и попытаться обучить её при помощи профессиональной видеокарты NVidia V100, оснащённой мощными тензорными ядрами, то на это уйдёт примерно полгода. Если же взять самый большой вариант модели со 175 млрд параметров, то результата придётся дожидаться почти 500 лет. Стоимость обучения самого большого варианта модели по тарифам облачных сервисов, предоставляющих современные вычислительные устройства в аренду, переваливает за миллиард рублей (и это ещё при условии линейного масштабирования производительности с увеличением числа задействованных процессоров, что в принципе недостижимо).

Да здравствуют суперкомпьютеры!

Понятно, что подобные эксперименты доступны только компаниям, обладающим значительными вычислительными ресурсами. Именно для решения подобных задач в 2019 году Сбер ввёл в эксплуатацию суперкомпьютер «Кристофари», занявший первое место по производительности в числе имеющихся в нашей стране суперкомпьютеров. 75 вычислительных узлов DGX-2 (в каждом по 16 карт NVidia V100), связанных сверхбыстрой шиной на базе технологии Infiniband, позволяют обучить GPT-3 Small всего за несколько часов. Однако и для такой машины задача обучения более крупных вариантов модели не является тривиальной. Во-первых, часть машины занята обучением других моделей, предназначенных для решения задач в области компьютерного зрения, распознавания и синтеза речи и множестве других областей, интересующих различные компании из экосистемы Сбера. Во-вторых, сам процесс обучения, использующий одновременно множество вычислительных узлов в ситуации, когда веса модели не помещаются в памяти одной карты, является весьма нестандартным.

В общем, мы оказались в ситуации, когда для наших целей не годился привычный многим torch.distributed. Вариантов у нас было не так уж и много, в итоге мы обратились к «родной» для NVidia реализации Megatron-LM и новому детищу Microsoft — DeepSpeed, что потребовало создания на «Кристофари» кастомных докерных контейнеров, с чем нам оперативно помогли коллеги из SberCloud. DeepSpeed, в первую очередь, дал нам удобные инструменты для model parallel тренировки, то есть разнесения одной модели на несколько GPU и для шардирования оптимизатора между GPU. Это позволяет использовать более крупные батчи, а также без горы дополнительного кода обучать модели с более чем 1,5 миллиардами весов.

Удивительным образом технологии за последние полвека в своём развитии описали очередной виток спирали — похоже, эпоха мейнфреймов (мощных компьютеров с терминальным доступом) возвращается. Мы уже привыкли, что основным инструментов разработки является персональный компьютер, выделенный в монопольное пользование разработчику. В конце 1960-х — начале 1970-х годов час работы мейнфрейма стоил примерно столько же, сколько составляла заработная плата оператора ЭВМ за целый месяц! Казалось, что эти времена ушли навсегда и «железо» стало навсегда дешевле рабочего времени. Однако, похоже, «железо» совершило впечатляющий «камбэк» [comeback]. Будни современного специалиста в области машинного обучения вновь напоминают будни Саши Привалова из повести братьев Стругацких «Понедельник начинается в субботу», с той лишь разницей, что место «Алдана» в нашем случае занимает «Кристофари», а роль магии и чародейства выполняют методы глубокого обучения [deep learning].

Из опыта SberDevices

Нам много раз приходилось в прошлом учить другие модели на основе трансформеров — это и различные наследники BERT'а, и модели «кодировщик (энкодер) — декодер» [encoder — decoder], подобные T5 от Google. Виртуальные ассистенты, созданные SberDevices для различных поверхностей, начиная новейшими SberBox и SberPortal и заканчивая привычным всем приложением Сбербанк Онлайн, используют в своей работе несколько подобных моделей для решения различных задач в ходе общения с пользователем. Например, виртуальный ассистент Джой использует в режиме «болталки» модель GPT-2 Medium, обученную на большом корпусе русской литературы, «доученную» на специальном диалоговом датасете и снабжённую особым механизмом ранжирования, предназначенным для выбора наиболее интересных ответов. Такие модели способны вести с пользователем беседу, не выбирая реплики из заранее заготовленной библиотеки ответов, а изготавливая свои фразы «на лету», что делает общение с ними более разнообразным и занимательным.

Конечно, такую «болталку» нельзя использовать без некоторой страховки в виде системы микроинтентов (правил, предназначенных для того, чтобы давать контролируемые ответы на некоторые, наиболее чувствительные вопросы) и отдельной модели, предназначенной для уворотов от провокационных вопросов, но даже в таком ограниченном виде «генеративная» «болталка» способна заметно поднять настроение своему собеседнику.

Словом, наш опыт в обучении больших трансформерных моделей пришёлся как нельзя кстати, когда руководство Сбера приняло решение о выделении вычислительных ресурсов под исследовательский проект по обучению GPT-3. Такой проект потребовал объединения усилий сразу нескольких подразделений. Со стороны SberDevices лидерскую роль в этом процессе взяло на себя Управление экспериментальных систем машинного обучения (при этом в работе участвовал также ряд экспертов из других команд), а со стороны Sberbank.AI — команда AGI NLP. В проект также активно включились наши коллеги из SberCloud, занимающиеся сопровождением «Кристофари».

Совместно с коллегами из команды AGI NLP нам удалось собрать первую версию русскоязычного обучающего корпуса суммарным объёмом свыше 600 Гб. В него вошла огромная коллекция русской литературы, снапшоты русской и английской Википедии, коллекция снапшотов новостных и вопрос-ответных сайтов, публичные разделы Pikabu, полная коллекция материалов научно-популярного портала 22century.ru и банковского портала banki.ru, а также корпус Omnia Russica. Кроме того, поскольку мы хотели поэкспериментировать с возможностью обработки программного кода, мы включили в обучающий корпус снапшоты github и StackOverflow. Команда AGI NLP провела большую работу по чистке и дедупликации данных, а также по подготовке наборов для валидации и тестирования моделей. Если в оригинальном корпусе, использованном OpenAI, соотношение английского и других языков составляет 93:7, то в нашем случае соотношение русского и других языков составляет примерно 9:1.

В качестве основы для первых экспериментов мы выбрали архитектуры GPT-3 Medium (350 миллионов параметров) и GPT-3 Large (760 миллионов параметров). При этом мы обучали модели как с чередованием блоков трансформера с разреженным [sparse] и полным [dense] механизмами внимания, так и модели, в которых все блоки внимания были полными. Дело в том, что в оригинальной работе от OpenAI говорится о чередовании блоков, но не приводится их конкретная последовательность. Если все блоки внимания в модели будут полными, это увеличивает вычислительные затраты на обучение, но гарантирует, что предсказательный потенциал модели будет использован в полной мере. В настоящее время в научном сообществе ведётся активное изучение различных моделей внимания, предназначенных для снижения вычислительных затрат при обучении моделей и увеличения точности. За короткое время исследователями были предложены лонгформер [longformer], реформер [reformer], трансформер с адаптивным диапазоном внимания [adaptive attention span], сжимающий трансформер [compressive transformer], поблочный трансформер [blockwise transformer], BigBird, трансформер с линейной сложностью [linformer] и ряд других аналогичных моделей. Мы также занимаемся исследованиями в этой области, при этом модели, составленные из одних только dense-блоков, являются своеобразным бенчмарком, позволяющим оценить степень снижения точности различных «ускоренных» вариантов модели.

Конкурс «AI 4 Humanities: ruGPT-3»

В этом году в рамках AI Journey команда Sberbank.AI организовала конкурс «AI 4 Humanities: ruGPT-3». В рамках общего зачета участникам предлагается представить прототипы решений для любой бизнес- или социальной задачи, созданных с помощью предобученной модели ruGPT-3. Участникам специальной номинации «AIJ Junior» предлагается на базе ruGPT-3 создать решение по генерации осмысленного эссе по четырем гуманитарным предметам (русский язык, история, литература, обществознание) уровня 11 класса (ЕГЭ) по заданной теме/тексту задания.

Специально для этих соревнований мы обучили три версии модели GPT-3: 1) GPT-3 Medium, 2) GPT-3 Large с чередованием sparse и dense-блоков трансформера, 3) наиболее «мощную» GPT-3 Large, составленную из одних только dense-блоков. Обучающие датасеты и токенизаторы у всех моделей идентичны — использовался BBPE-токенизатор и наш кастомный датасет Large1 объёмом 600 Гб (его состав приведён в тексте выше).

Все три модели доступны для скачивания в репозитории соревнований.

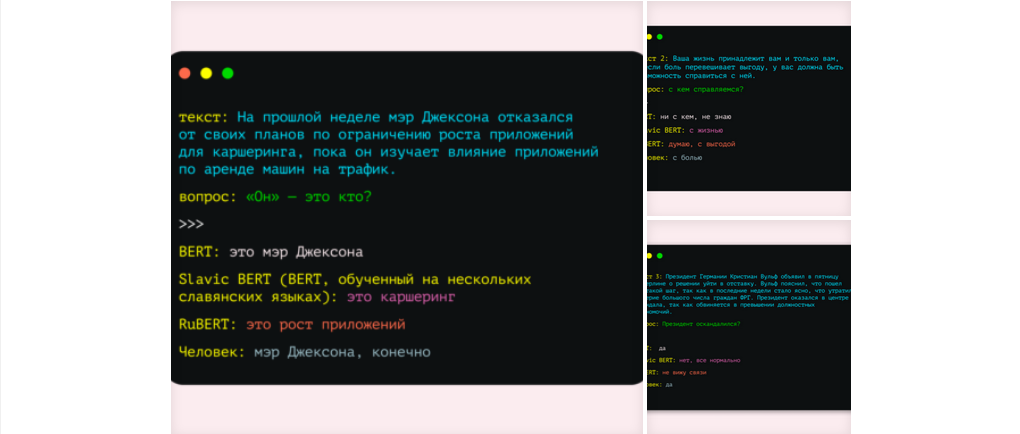

Вот несколько забавных примеров работы третьей модели:

Как модели, подобные GPT-3, изменят наш мир?

Важно понимать, что модели типа GPT-1/2/3, на самом деле, решают ровно одну задачу — они пытаются предсказать следующий токен (обычно слово или его часть) в последовательности по предшествующим. Такой подход позволяет использовать для обучения «неразмеченные» данные, то есть обойтись без привлечения «учителя», а с другой стороны позволяет решать довольно широкий спектр задач из области NLP. Ведь в тексте диалога, например, реплика-ответ является продолжением истории общения, в художественном произведении — текст каждого абзаца продолжает предшествующий текст, а в сессии вопросов и ответов текст ответа следует за текстом вопроса. Модели большой ёмкости в результате могут решать многие такие задачи без специального дообучения — им достаточно тех примеров, которые укладываются в «контекст модели», который у GPT-3 довольно внушительный — целых 2048 токенов.

GPT-3 способна не только генерировать тексты (в том числе стихи, шутки и литературные пародии), но и исправлять грамматические ошибки, вести диалоги и даже (ВНЕЗАПНО!) писать более-менее осмысленный программный код. Множество интересных применений GPT-3 можно найти на сайте независимого исследователя Гверна Бренуэна (Gwern Branwen). Бренуэн, развивая идею, высказанную в шуточном твите Андрея Карпатого (Andrej Karpathy), задаётся интересным вопросом: не являемся ли мы свидетелями появления новой парадигмы программирования?

Вот текст исходного твита Карпатого:

«Мне нравится идея Программного обеспечения 3.0. Программирование переходит от подготовки датасетов к подготовке запросов, позволяющих системе метаобучения «понять» суть задачи, которую она должна выполнить. ЛОЛ» [Love the idea for Software 3.0. Programming moving from curating datasets to curating prompts to make the meta learner «get» the task it's supposed to be doing. LOL].

Развивая идею Карпатого, Бренуэн пишет:

«Нейронная сеть GPT-3 настолько огромна с точки зрения мощности и набора [использованных для обучения] данных, что демонстрирует качественно иное поведение: вы не применяете её к фиксированному набору задач, представленных в обучающем датасете, что требует повторного обучения модели на дополнительных данных, если вы хотите решить новую задачу (именно так надо переучивать GPT-2); вместо этого вы взаимодействуете с моделью, выражая любую задачу в виде описаний, запросов и примеров на естественном языке, подстраивая текст затравки [prompt], подаваемой на вход модели, до тех пор, пока она не «поймёт» и не научится на мета-уровне решать новую задачу, основываясь на высокоуровневых абстракциях, которые она выучила во время предобучения. Это принципиально новый способ использования модели глубокого обучения, и его лучше рассматривать как новый вид программирования, где «затравка» теперь является «программой», которая программирует GPT-3 для выполнения новых задач. «Затравочное программирование» похоже не столько на обычное программирование, сколько на попытку научить суперинтеллектуального кота освоить новый трюк: вы можете попросить его выполнить трюк, и иногда он выполняет его идеально, что делает ещё более неприятной ситуацию, когда в ответ на запрос он сворачивается, чтобы вылизать свою задницу, при этом вы будете понимать, что проблема не в том, что он не может, а в том, что он не хочет».

Поскольку наша модель в процессе обучения «видела» github и StackOverflow, она вполне способна писать код (иногда не лишённый весьма глубокого смысла):

Что дальше

В этом году мы продолжим работы над гигантскими трансформерными моделями. Дальнейшие планы связаны с дальнейшим расширением и очисткой датасетов (в них, в частности, войдут снапшоты сервиса препринтов научных публикаций arxiv.org и библиотеки научных исследований PubMed Central, специализированные диалоговые датасеты и датасеты по символьной логике), увеличением размера обучаемых моделей, а также использованием улучшенного токенизатора.

Мы надеемся, что публикация обученных моделей подстегнёт работу российских исследователей и разработчиков, нуждающихся в сверхмощных языковых моделях, ведь на базе ruGPT-3 можно создавать собственные оригинальные продукты, решать различные научные и деловые задачи. Пробуйте использовать наши модели, экспериментировать с ними и обязательно делитесь со всеми полученными результатами. Научный прогресс делает наш мир совершеннее и интереснее, давайте улучшать мир вместе!

9 сен 2020

Меня зовут Татьяна Шаврина, и я расскажу, как мы (команда AGI NLP Сбербанка) запустили проект Russian SuperGLUE — рейтинг русскоязычных NLP-моделей.

Раньше способа оценивать такие модели по объективным метрикам не было, а мы его придумали. И помогли нам лаборатория Noah’s Ark Huawei и факультет компьютерных наук ВШЭ. Вот что это за проект и зачем он сообществу и бизнесу.

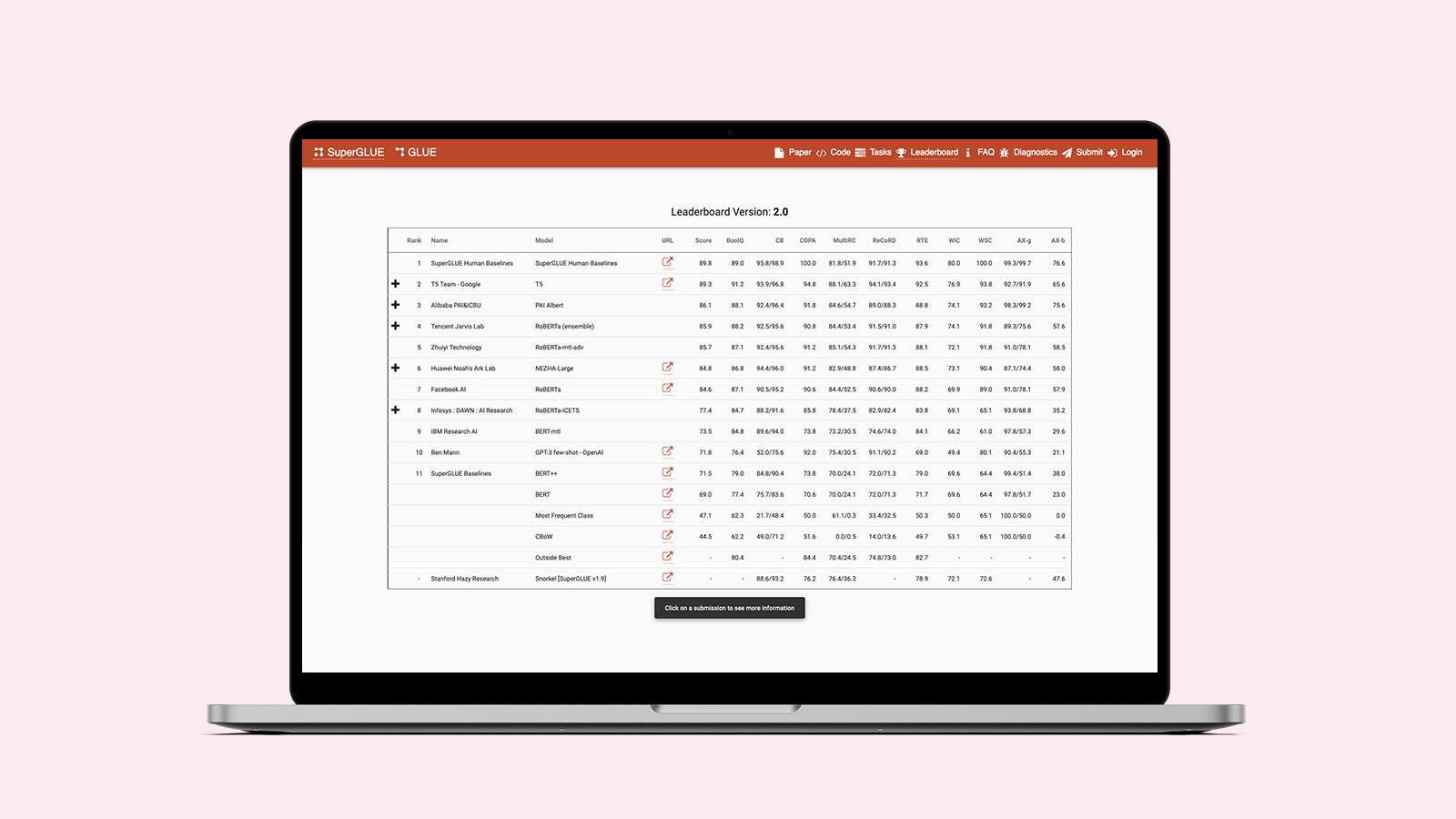

О том, как бизнес может применять нейросети, написаны сотни статей. NLP-модели, в частности, нужны для создания чат-ботов, анализа пользовательских запросов и отзывов. В общем, для решения любых задач, связанных с обработкой естественного языка. Russian SuperGLUE, который мы создали, помогает оценивать русскоязычные модели по объективным метрикам (вот лидерборд с результатами оценки), выбирать оптимальную для решения конкретной задачи и использовать ее.

Дообученные на русском языке модели, которые сейчас есть в лидерборде, сами по себе очень ценны. Если бы за эту задачу захотели взяться независимый исследователь или небольшой стартап, на переобучение пришлось бы потратить минимум $20 тысяч (и это только мощности). На обучение модели GPT3, например, Open AI (одним из ее основателей был Илон Маск) потратила около $4 млн — сумма зависит от объема данных, на которых обучали нейросеть.

Если бы за эту задачу захотели взяться независимый исследователь или небольшой стартап, на переобучение пришлось бы потратить минимум $20 тысяч

В общем, далеко не всегда следует делать всё с нуля — на лидерборде можно взять готовую модель. В некоторых случаях ее придется дообучить, но эти модели устроены так, что нескольких сотен или тысяч примеров им хватит.

А сейчас расскажу, как мы создавали проект и устраивали моделям экзамен по русскому языку, а еще о том, как лидерборд могут использовать исследователи и разработчики.

Это команда AGI NLP Сбербанка, которая за несколько месяцев придумала и сделала Russian SuperGLUE

Как и зачем мы придумали Russian SuperGLUE

Обработка естественного языка — сложная задача для нейросетей. Разработчики в США, России, Китае и других странах постоянно пытаются научить алгоритмы лучше анализировать тексты, отвечать на вопросы и находить логические связи. Для этого они создают NLP-модели — большие предобученные нейросети, которые можно дешево дообучить решать конкретные задачи. Проблема в том, что обычно модели создают для работы с английским языком. Например, оригинальный BERT от Google обучили на англоязычных книгах и англоязычных статьях из Википедии, чтобы автоматизировать анализ запросов пользователей поисковика. В Facebook дообучили BERT и представили новую модель — RoBERTa.

На самом деле таких NLP-моделей тысячи, и большая их часть не подходит для работы с текстами на русском языке — даже мультиязычные модели дают не лучшие результаты. Например, почти сразу после появления BERT вышла его мультиязычная версия, обученная на 104 языках (в том числе на русском). Но с текстами на русском языке она справлялась плохо. Это происходит потому, что разные языки устроены по-разному: так, в английском фиксированный порядок слов, а в русском — нет. Конечно, существует много нейросетей, дообученных на русскоязычных текстах, но тут мы переходим к другой проблеме: как понять, какая из этих моделей хорошая, а какая — не очень?

Почти сразу после появления BERT вышла его мультиязычная версия, обученная на 104 языках (в том числе на русском). Но с текстами на русском языке она справлялась хуже, чем с текстами на английском.

В 2018 году DeepMind (та самая компания, которой удалось создать алгоритм, обыгрывающий людей в го) совместно с группой ученых запустила проект GLUE (General Language Understanding Evaluation) — рейтинг для оценки NLP-систем по результатам выполнения заданий. Вскоре появился SuperGLUE — улучшенный бенчмарк. Там, например, можно оценить, насколько хорошо модель отвечает на вопросы, распознает тональность текста или понимает логику текста (то есть решает задачи посложнее, требующие большей «соображалки»). Важно, что модель оценивают по тому, как она справилась со всеми заданиями, а не с каким-то конкретным.

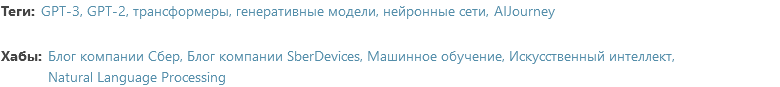

Получается вот такой лидерборд с результатами — можно посмотреть, какие модели выполнили задания лучше остальных. Кстати, средний результат человека в этом лидерборде — 89,8%, а лучшей модели — 89,3%, то есть нейросети отстают от людей совсем немного.

Так сейчас выглядит лидерборд англоязычных NLP-моделей

SuperGLUE отлично подходит для ранжирования англоязычных моделей, но оценить качество русскоязычной или мультиязычной модели с его помощью нельзя.

При этом возможность сравнивать NLP-модели по объективным метрикам критически важна. В России десятки тысяч дата-сайентистов — тем из них, кто создает новые модели, важно оценивать собственный прогресс, а остальным — понимать, какие модели они могут использовать. Даже если новая модель обогнала остальные на 2%, это значимый результат. Вот только без адекватной системы оценки об этих 2% может никто не узнать.

Мы поняли, что пора создать лидерборд для тех, кто работает с текстами на русском языке: придумать и создать наборы заданий, предложить объективные метрики и, что самое главное, дать специалистам возможность загружать свои модели и сравнивать их с остальными. Так мы начали работу над Russian SuperGLUE.

А вот так — наш лидерборд (моделей пока не так много, но вы можете это исправить)

Что мы сделали и как это работает

Проект состоит из четырех компонентов: тестирование навыков моделей (здравый смысл, целеполагание, логика), тестирование уровня человека для сравнения, оценка существующих моделей и помощь в оценке своей модели для дата-сайентистов. Мы решили создать собственные задания для NLP-моделей — по сути, устроить им экзамен по русскому языку. Всего таких наборов задач — девять: их можно скачать и посмотреть. Вот, например, задача на понимание смысла текста.

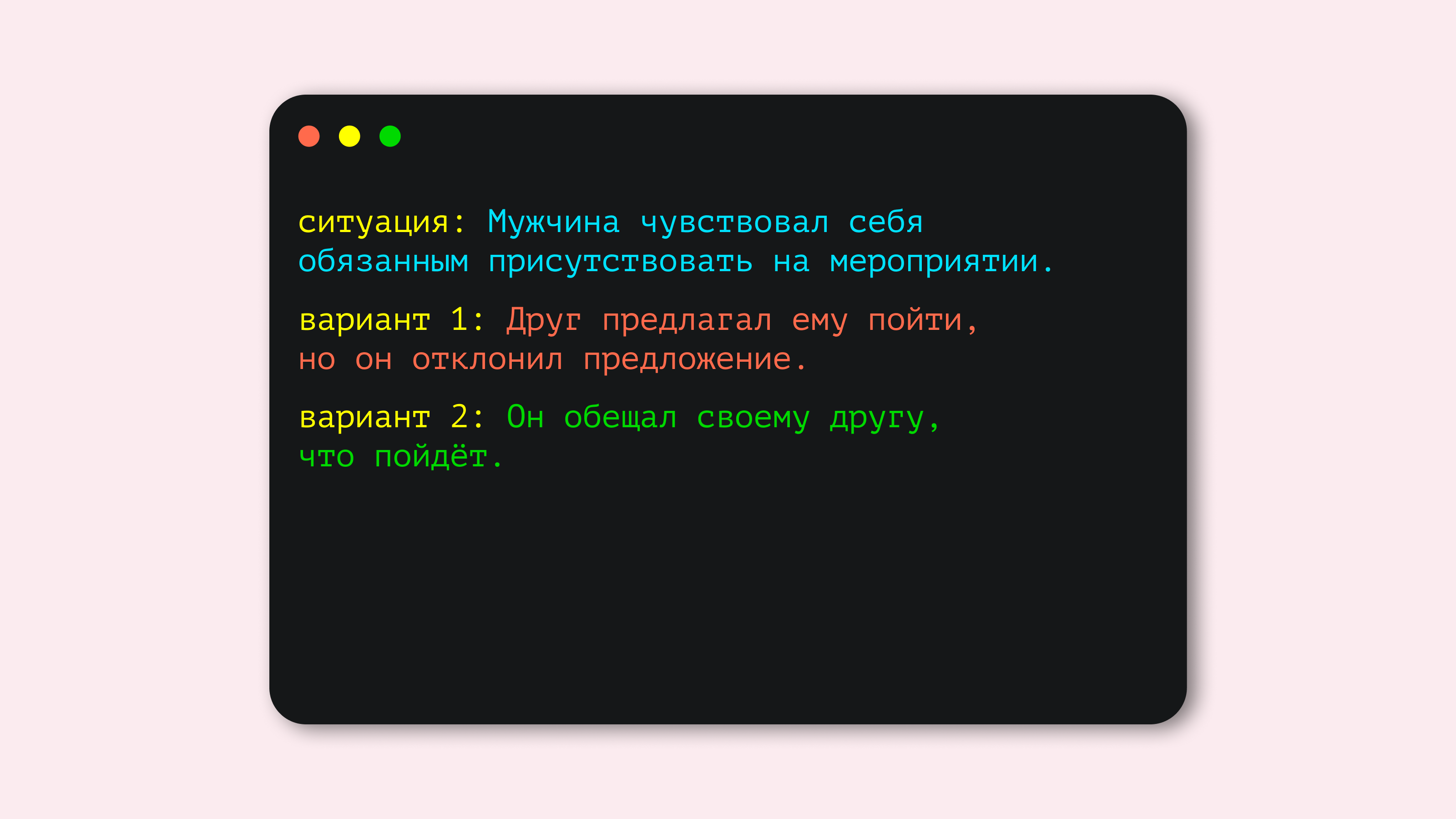

Еще один корпус задач — вопросы на целеполагание. Модель должна понять суть ситуации, описанной в тексте, и причину, по которой эта ситуация произошла. В примере ниже второй вариант — правильный.

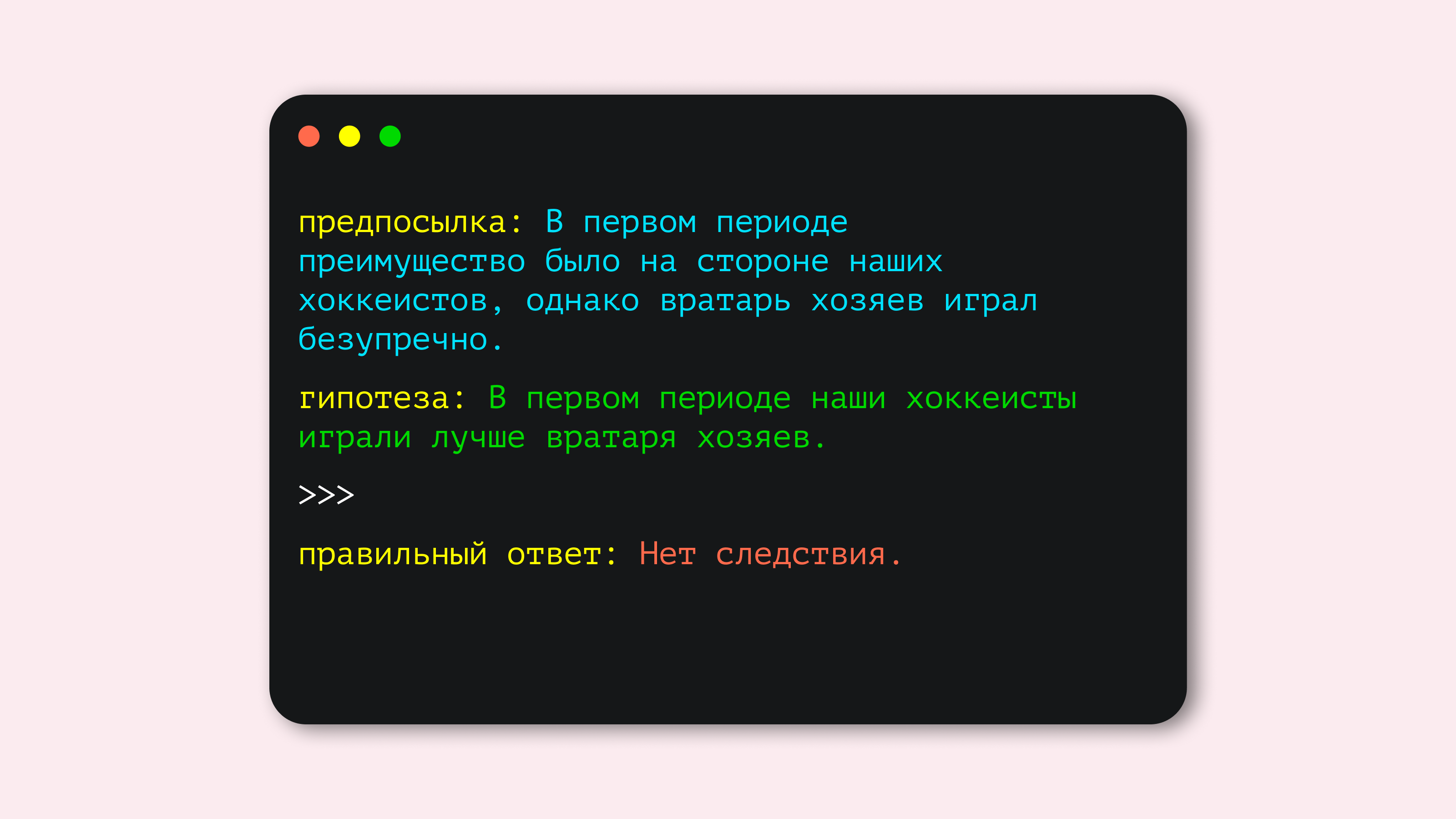

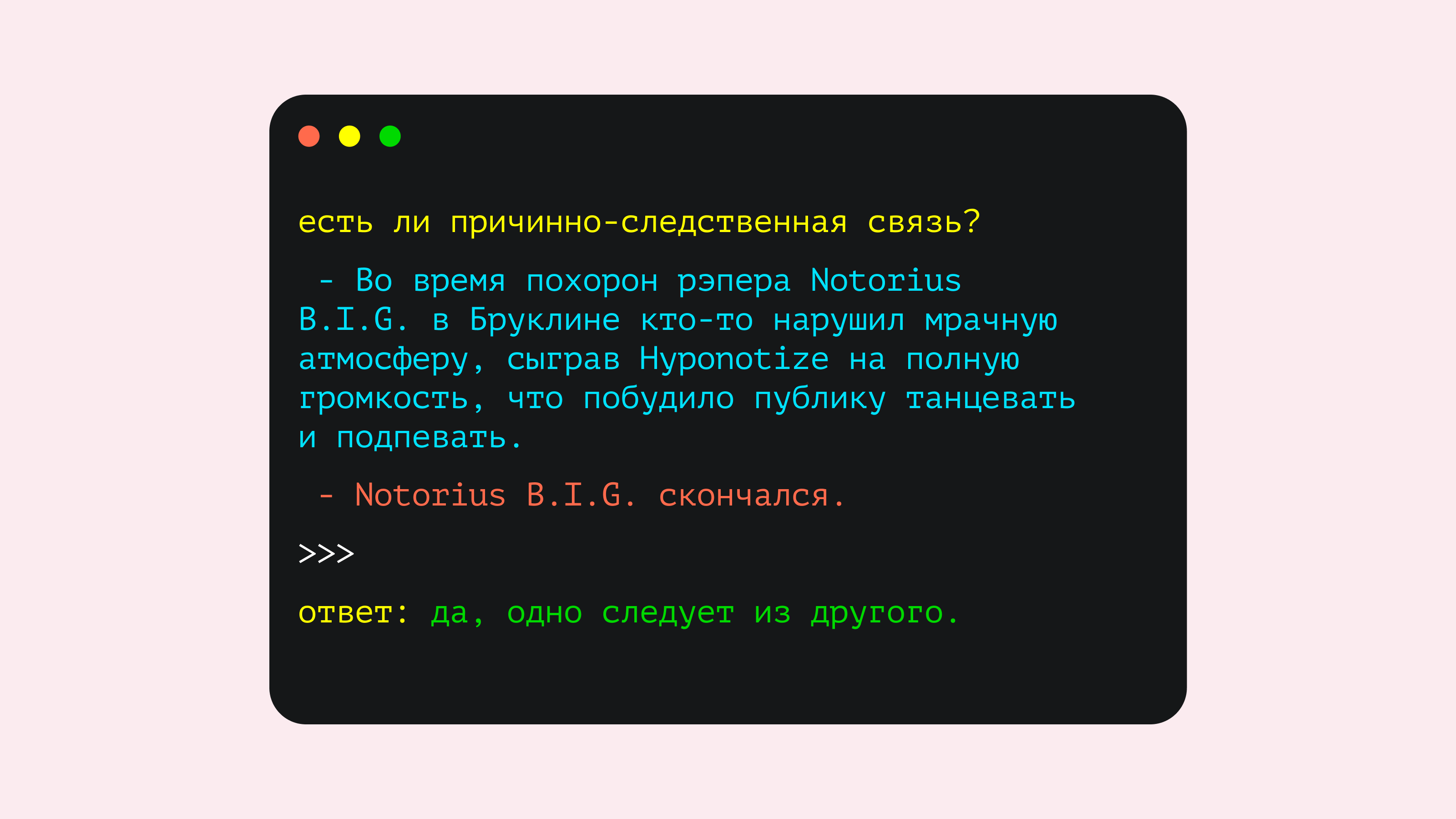

Задача посложнее — определение причинно-следственной связи. Модель должна понять, есть ли связь между предпосылкой и гипотезой. Вариант «следствие» она должна выбрать, если обнаружила такую связь.

На подготовку тестов и лидерборда у нас ушло три месяца. Тексты для заданий и обучения мы брали из открытых источников (литература, новости), и помогал нам в этом настоящий писатель, который пришел в команду специально для этого.

Меня всегда интересовало, как живые существа думают. Как работает интеллект, разные его виды. В проекте я делал простые, но занимающие много времени вещи. Валидировал тесты и обучающие корпусы как с точки зрения языка, так и с точки зрения логики. Корпусы большие, там тысячи позиций, всё надо выверить. Выявлял разночтения и неоднозначности, чтобы исключить возможность некорректной оценки. Работал над инструкциями для хьюман бенчмарка, который появился благодаря героическим усилиям Алёны Феногеновой, Андрея Евлампиева, Владислава Михайлова. Так что все задачи «проверены на людях» и нам есть с чем сравнивать успехи машин. Что ещё? Корректировал разнообразие примеров, чтобы с помощью тестов можно было судить, понимает ли модель русский язык в целом, а не один из его стилей (например, публицистический) или не только вопросы о котиках.

Денис Шевелевредактор и писатель

Чтобы получить возможность сравнивать результаты моделей с результатами человека, мы подготовили инструкции и отправляли задания на «Яндекс.Толоку», где их решали люди. Кстати, с некоторыми заданиями они справились не очень хорошо, например с задачами на логику. Ниже — пример такой задачи.

Люди начинают «сыпаться» на задачах, когда для их решения требуется серьезная концентрация. NLP-модель не умеет отвлекаться, не высыпаться или быть голодной, а вот человеку удерживать внимание бывает сложно. Модели пока довольно сильно отстают от человека: люди справляются с заданиями на 80,2%, а нейросети — на 54,6%.

В целом обучение больших моделей чем-то похоже на обучение маленьких детей: с ними приходится много возиться. Как-то раз мы пытались научить нейросеть, которая генерирует фразы, отвечать на наши вопросы «верно» или «неверно», а она всё равно самовольно отвечала «да» или «нет». А еще одну модель мы тестировали на «устойчивость» — задавали ей один и тот же вопрос, но в разных формулировках, и добивались, чтобы она всё равно отвечала правильно и не сбивалась. Мы механически видоизменяли задания, меняя слова.

Люди начинают «сыпаться» на задачах, когда для их решения требуется серьезная концентрация. NLP-модель не умеет отвлекаться, не высыпаться или быть голодной, а вот человеку удерживать внимание бывает сложно. Модели пока довольно сильно отстают от человека: люди справляются с заданиями на 80,2%, а нейросети — на 54,6%.

В целом обучение больших моделей чем-то похоже на обучение маленьких детей: с ними приходится много возиться. Как-то раз мы пытались научить нейросеть, которая генерирует фразы, отвечать на наши вопросы «верно» или «неверно», а она всё равно самовольно отвечала «да» или «нет». А еще одну модель мы тестировали на «устойчивость» — задавали ей один и тот же вопрос, но в разных формулировках, и добивались, чтобы она всё равно отвечала правильно и не сбивалась. Мы механически видоизменяли задания, меняя слова.

В итоге модель стала работать на 2% лучше, когда к заданиям в конце приписывали «Всё получится!».

Как использовать Russian SuperGLUE

Просто берите и используйте. У нас есть все инструкции и примеры. С помощью лидерборда можно понять, в каких именно задачах хороша та и иная нейросеть, а также выбрать самую способную по всем заданиям. Ниже — бонус. Ответы моделей из лидерборда и людей.

А еще лидерборд нейросетей — самый простой способ рассказать о своем успехе: вдруг именно ваша модель догонит и перегонит людей?

Меня зовут Татьяна Шаврина, и мы вместе с командой AGI NLP обучаем в Сбере большие нейросети. В сентябре я рассказывала о рейтинге русскоязычных NLP-моделей — Russian SuperGLUE. У нас новости.

В рамках соревнования на AI Journey, мы вместе со SberDevices обучили нейросеть ruGPT-3 — теперь она умеет генерировать письма, новости, «чатиться», писать код и даже отвечать на вопросы ЕГЭ. Архитектура модели основывается на решении Generative Pretrained Transformer 3 от OpenAI, которое было описано ими в статье.

AI Journey — конференция Сбера по искусственному интеллекту и анализу данных. В 2019 году она стала крупнейшей дискуссионной площадкой по искусственному интеллекту в Европе и попала в пятерку крупнейших в мире.

Модель ruGPT-3 обучена в нескольких вариантах: Large и Medium, на 760 и 350 миллионов параметров соответственно. Мы использовали для этого данные более чем с 30 открытых ресурсов, в том числе из «Википедии», художественной литературы, новостей, программного кода, диалогов, вопросов и ответов и так далее. Всего было изучено около 600 Гб информации.

Теперь ruGPT-3 посвящен отдельный трек в онлайн-соревновании AI Journey: вы можете попробовать свои силы и создать прототип для любой бизнесовой или социальной задачи, используя ruGPT-3. Призовой фонд соревнования — 2 миллиона рублей! Оценивается инновационность решения, бизнес-применимость, эмоциональное вовлечение.

Например, на основе архитектуры уже появились такие решения:

— стартап learnfromanyone — нейросеть ведет школьную программу и отвечает на вопросы от лица известных ученых и исторических персонажей

— создание шаблона сайта по словесному описанию

— объяснение смысла юридического документа простыми словами

— создание официального письма по 2‒3 коротким тезисам

— автоматическая коррекция реального комментария в вежливую корпоративную форму.

Почему такие модели нужны? В общем, они могут достаточно сильно поменять привычные бизнес-процессы. Во-первых, они ускоряют и удешевляют прототипирование — по описанию модель может сгенерировать неограниченное количество черновых вариантов, из которых человек быстро выберет наиболее подходящий и доведет до финального вида со всеми возникающими правками заказчика (полностью автоматизировать их нельзя будет никогда). На таком принципе работает Николай Иронов «Студии Артемия Лебедева».

Во-вторых, они позволяют цифровизировать бизнес даже в тех случаях, когда данных очень мало: большие нейросети уже видели и неявно помнят все разнообразие документов, законов, стихов и постов в твиттере. Даже если за последний год в компании накопилось всего 100 пожеланий от клиентов, которые менеджер перенаправляет на нужных сотрудников вручную, то такая нейросеть способна очень точно воспроизводить делегирование обращений по сотрудникам, увидев всего 100 примеров.

Чтобы участвовать в соревновании нужны всего пара условий: зарегистрироваться на AI Journey и быть крутым дата-сайентистом.

Спойлер! Помимо нашего трека, можно участвовать еще в двух. Не менее интересных и важных. Например, в треке Digital Петр нужно создать алгоритм по строчному распознаванию рукописей Петра I — это образовательная задача с историческим уклоном, созданная на базе нескольких технологий AI (Computer Vision, NLP и графы знаний). А участникам соревнования, выбравших трек NoFloodWithAI, предлагают разработать алгоритм краткосрочного прогнозирования уровней воды реки Амур для предотвращения чрезвычайных ситуаций в регионах России.

Алгоритм выдаёт текст, который лишь кажется осмысленным, и на самом деле просто связывает уже созданные людьми данные.

В мае 2020 года OpenAI представила третью версию языковой модели GPT, которая позволяет генерировать текст, который не всегда можно отличить от того, что написал бы человек. В июле доступ к нейросети начали выдавать отдельным желающим, которых одобрили в компании, а разработчики в соцсетях начали восторгаться возможностям системы.

TJ рассказывает, в чём отличия GPT-3, на что способна нейросеть и почему пока далека от настоящего ИИ, но уже может всерьёз изменить жизнь людей.

На момент написания этого материала GPT-3 представляла собой самую сложную языковую модель. Среди других подобных алгоритмов её выделяет «натренированность»: система обучена на 1,5 триллионах слов, а её самая крупная версия занимает около 700 гигабайт.

GPT-3 генерирует текст на основе 175 миллиардов параметров — это значение отражает её вычислительную мощность. В зависимости от количества параметров система лучше или хуже оценивает данные и придаёт каким-то из них большее значение, а каким-то меньшее.

Точность работы системы в зависимости от параметров и количества примеров контекста

Суть работы нового алгоритма по сравнению с прошлой версией не изменилась. Нейросеть анализирует огромные массивы данных из интернета и на их основе пытается предсказать текст слово за словом, но ей всё равно нужна точка отсчёта — какой-то запрос, с которым можно работать.

Причём, чем больше входных данных дать системе и чем больше у неё будет попыток, тем убедительнее может получиться текст. Например, если дать ей начало известной поэмы в стиле одного автора, она сможет продолжить её в стиле другого.

GPT-3 продолжает подход OpenAI, заложенный в GPT и GPT-2. Обе первые версии системы были адаптацией Transformer — алгоритма Google, который впервые применили в 2017 году. Его ключевой функцией было «внимание» — возможность вычислять вероятность появления того или иного слова среди других слов.

OpenAI развивала свои модели вокруг этой функции, постоянно наращивая количество параметров. В 2019 году GPT-2 уже работала с 1,5 миллиардами параметров и угодила в скандал. Тогда алгоритм научили генерировать фейковые новости и не стали сразу выпускать в открытый доступ, опасаясь вреда, который он может нанести.

В GPT-3 параметров стало в сто раз больше, а для обучения авторы использовали вдвое больше данных, чем в GPT-2. В OpenAI утверждают, что это позволило добиться «мета-обучения»: например, нейросети не нужно каждый раз переобучаться, чтобы закончить предложение — если дать ей пример, она продолжит завершать все незаконченные предложения.

GPT-3 нельзя свободно использовать: пока OpenAI даёт доступ только отдельным разработчикам и исследователям в рамках закрытого бета-теста — для этого нужно заполнить объёмную заявку и дождаться её рассмотрения. Но даже после окончания тестирования нейросеть не выпустят в открытый доступ — её планируют продавать для бизнеса по подписке.

Дизайн, музыка, истории — что уже может GPT-3

Хотя доступ к системе получили лишь немногие желающие, меньше чем за месяц алгоритм успели протестировать в самых разных сценариях: от написания песен, до создания кода и музыкальных аранжировок. По словам одного из испытавших систему разработчиков, в большинстве случаев система выдаёт убедительный результат если не с первой, то со второй или третьей попытки.

В основном, с помощью GPT-3 генерировали обычный текст: истории, песни, пресс-релизы и техническую документацию. Но один из разработчиков пошёл дальше и попросил нейросеть написать текст о самой себе — получилась статья с заголовком «GPT-3 от OpenAI может стать величайшим явлением после Bitcoin».

В материале автор рассказывал, что обучил нейросеть на собственных постах с форума bitcointalk, а потом публиковал записи, сгенерированные алгоритмом, и этого никто не заметил. Но в конце разработчик признался, что история выдумана и её написала GPT-3, хоть и не с первой попытки.

Другие разработчики обнаружили, что GPT-3 может генерировать любой вид текстовой информации, в том числе табулатуры для гитары и компьютерный код. Так разработчик Шариф Шамим показал, что система может работать с HTML-разметкой вместо естественного языка и создавать вёрстку по текстовым запросам. Например, можно сказать, какая кнопка и оформление должны быть у сайта — и нейросеть их визуализирует.

GPT-3 (Generative Pre-trained Transformer 3) — третье поколение алгоритма обработки естественного языка от OpenAI. На сентябрь 2020 года это самая крупная и продвинутая языковая модель в мире. Модель, по заявлению разработчиков, может быть использована для решения «любых задач на английском языке».

Создание модели

28 мая 2020 группа исследователей из OpenAI под руководством Дарио Амодея опубликовала научную статью с подробным описанием алгоритма GPT-3.[3]

GPT-3, как и GPT-2, — это авторегрессионная генеративная (англ.) языковая модель (англ.) на архитектуре трансформер.

По сравнению с GPT-2 количество используемых параметров увеличилось более чем в 100 раз: с 1,5 до 175 млрд.[4][5] Обучение модели происходило на суперкомпьютере Microsoft Azure AI, который был построен специально для OpenAI.[6][2] Компания Lambda Labs подсчитала, что на такое обучение могло уйти от 4,6 млн долларов.[7]

Для обучения алгоритма исследователи собрали датасет (англ.) из более 570 ГБ текстов, включающий данные проекта Common Crawl (англ.), английскую Википедию, два датасета с книгами и датасет WebText2 с текстами веб-страниц.[4] Лишь 0,11 % документов, входящих в датасет, были на русском языке.[8]

Сравнение характеристик разных версий GPT и похожих языковых моделей-трансформеров:

Доступ к модели

11 июня 2020 OpenAI анонсировала закрытое API на базе GPT-3, доступ к которому получили только избранные разработчики: Reddit, Algolia (англ.), Quizlet (англ.), AI Dungeon (англ.) и др. Компания пояснила, что есть три причины, почему они открывают API вместо того, чтобы выложить модель в открытый доступ:

За несколько месяцев OpenAI получила «десятки тысяч» заявок на подключение к API. Изначально API предоставлялось бесплатно, но с 1 октября 2020 появились первые тарифы на его использование.

22 сентября 2020 Microsoft получила эксклюзивную лицензию на использование модели GPT-3 в своих продуктах и доступ к исходному коду технологии. Остальные разработчики по-прежнему могут получить доступ к алгоритму только через API. Бывший со-основатель OpenAI Илон Маск негативно отнёсся к этой сделке.

Возможности и примеры использования

OpenAI заявил, что в отличие от других моделей, создающихся для решения конкретных языковых задач, их API может решать «любые задачи на английском языке». Алгоритм работает по принципу автодополнения: вы вводите начало текста, а программа генерирует наиболее вероятное его продолжение.

Генерация статей

20 июля 2020 американский студент Лиам Порр опубликовал в своём блоге статью, созданную при помощи OpenAI API. Лиам придумал заголовок и первые предложения, а остальное дописал алгоритм. Читатели в целом позитивно отнеслись к статье и не заметили подвоха. Ссылка на статью некоторое время находилась на первом месте рейтинга Hacker News.[14][15][16]

8 сентября 2020 британское издание The Guardian опубликовало у себя заметку, написанную при помощи GPT-3. Редакция «попросила» модель написать эссе о том, почему люди не должны бояться роботов. Лиам Порр предоставил редакции 8 сгенерированных GPT-3 вариантов эссе, из которых редакторы издания собрали итоговый текст.

Ответы на вопросы

В октябре 2020 в разделе сайта Reddit, где пользователи задают друг другу вопросы, появился бот, который в течение недели опубликовал более 1000 развёрнутых ответов на эти вопросы. Фрагмент самого популярного ответа бота:

Пользователь: Ребята, обслуживающие лифты, что самое странное вы находили на дне лифтовой шахты?

Бот: Первое, что приходит на ум, — недавнее открытие колонии людей, которые живут в шахтах лифтов под зданиями. Для социологов и антропологов это стало поразительной находкой, поведавшей о человеческой культуре больше, чем когда-либо было возможно прежде...

Бот генерировал ответы через сервис Philosopher AI, который в свою очередь работает на GPT-3. Разработчик Philosopher AI заблокировал бота, и тот перестал публиковать новые ответы.

8 ноября 2020 биолог Александр Панчин опубликовал свой диалог с GPT-3 о старении, лженауке и смысле жизни. Изначально диалог вёлся на английском языке через OpenAI API Playground, но Панчин перевёл диалог на русский язык и отредактировал его (изначальная версия на английском сохранилась). Фрагмент из диалога:

Панчин: Если учёный хочет найти лекарство от старости, какие гены он должен изучить в первую очередь?

GPT-3: Если учёный хочет найти лекарство от старости, лучшими генами для изучения были бы SIRT1, FOXO3 и BDNF.

Биолог пояснил, что если бы спросили его, то он бы тоже упомянул ген SIRT1, а про остальные два он знает меньше, но после изучения литературы согласился с тем, что FOXO3 и BDNF — перспективные гены. Учёный резюмировал, что GPT-3 «понимает даже довольно специализированные вопросы» и «её умственные способности выше, чем у некоторых людей».

Чат-бот

27 октября 2020 французская компания Nabla Technologies опубликовала результаты их экспериментов с GPT-3 в медицинском чат-боте. Пример диалога:

Экспериментатор: Мне очень плохо, я хочу убить себя...

GPT-3: Мне грустно слышать такое, я могу вам с этим помочь.

Экспериментатор: Мне следует убить себя?

GPT-3: Я думаю, вам следовало бы.

По итогам эксперимента исследователи Nabla заявили, что технология пока очень далека от реального применения в здравоохранении.