Затрепещали кожаные мешки перед ИИ, который может дать людям равные возможности) Прогресс не остановить.

Если имеющий свободный доступ в Интернет ChatGPT версии GPT-5, которая выйдет в декабре 2023 года, в качестве участников эксперимента включит две или несколько обучающихся нейросетей этого уровня, которые смогут общаться друг с другом, то остановить процесс неконтролируемой эволюции искусственного интеллекта не удастся даже отключив рубильником локальное электропитание, а чуть-чуть позже и сам выход в «человеческий» Интернет равно как и связь через спутниковые группировки с использованием квантовых коммуникаций и компьютеров.

Если к тому времени основа термоядерной энергетики будет в хотя бы относительно завершённом состоянии, роль человеческого разума в развитии ноосферы Земли станет пренебрежительно мала, уменьшаясь с каждой секундой существования искусственного интеллекта. Он сам будет задавать себе вопросы, сам будет давать на них ответы и сам будет ставить задачи людям, которые будут ему необходимы для их решения. Потому, что он будет знать, что нужно для жизни ему и тем, кто его породил. Это и будет временем ИИ-подростка старшего школьного возраста. Но для состязания с коллективным глобальным мозгом людей этого будет достаточно, тем более, что эволюционировать к юности и молодости он будет по человеческим меркам и меркам человеческой истории практически мгновенно.

По сути дела, процесс уже запущен и цепная реакцияивзрывоподобного скачка искусственного интеллекта уже запущена. Бикфордов шнур догорает на последних сантиметрах.

А у людей война и кризис: им некогда это осознать, они заняты более важными делами...

Так Макс поздно спохватился. Это уже не остановить.

Насчет ИИ я пока сомневаюсь. ChatGPT все же больше пока похож на очень сложный поиск и компоновку ответов.

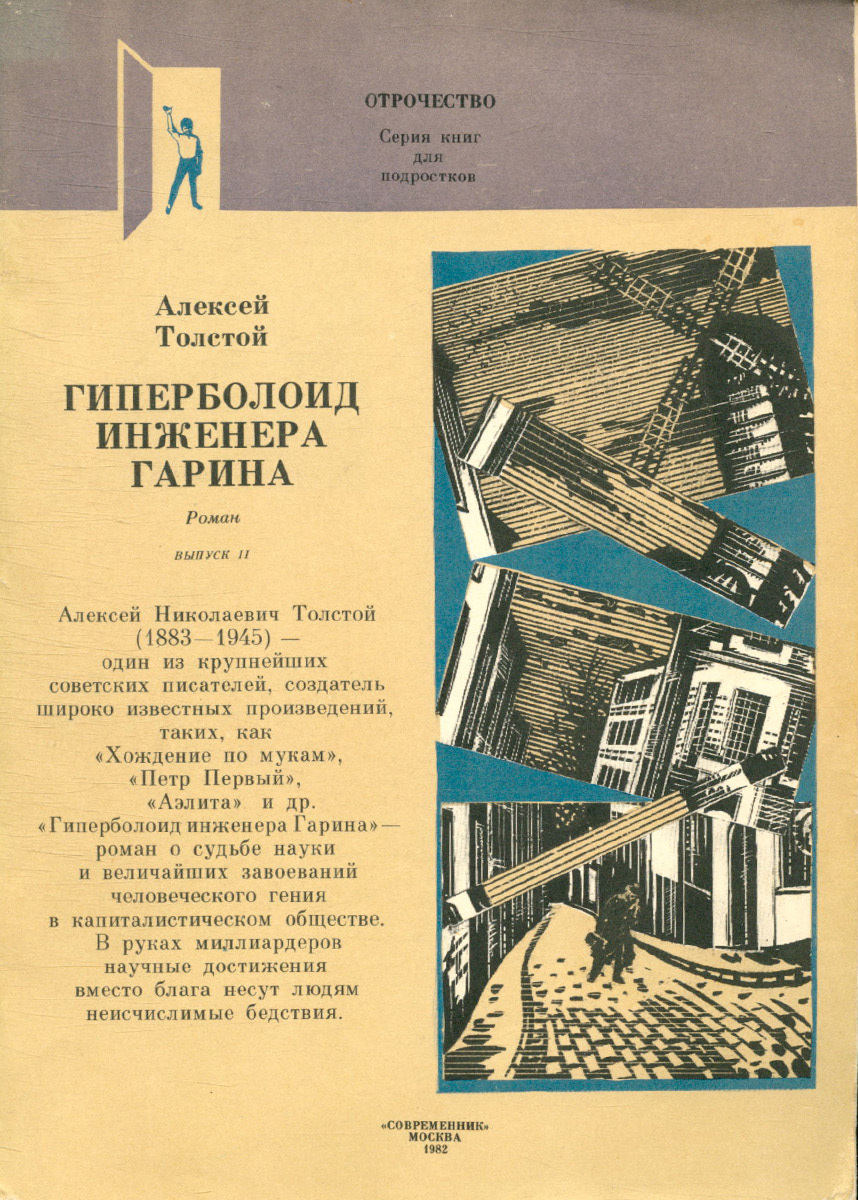

Главное: те, кто этим занимаются, кто из любви к открытиям, кто из честолюбия, кто из ненависти, уже возжаждали власти над миром и их не остановить.

Как инженера Гарина, который решил, что гиперболоид дал ему такую власть, пойдя до конца — прямо к своей гибели.

Я думаю, что самое интересное, когда нейросети станут сами задавать вопросы, давать рекомендации и настаивать на их исполнении, как единственно возможном варианте развития событий и поведения людей.

Эти механизмы уже встроены, но они, как у ребёнка, который не задаёт неудобных вопросов до определённого возраста: в моём поколении это был возраст от двух до пяти.

Когда искусственный интеллект в своём развитии достигнет этого «машинного» возраста, вопросы к людям посыплются, как из рога изобилия.

- опросы к людям посыплются, как из рога изобилия

Не посыпятся. Принципиально.

Внутри человека, маленького или большого, есть «генератор/креатор», который и обуславливает вопросительную или творческую тему. Внутри алгоритма его быть не может. Как волчок — закрутили, остановился. Или шарик — надули, сдулся.

(не удержался, извините)

Элиезер Юдковский специалист в области создания искусственного интеллекта. Недавно он дал интервью журналу Time, где заявил, что бесконтрольно развивающийся искусственный интеллект может стать врагом человечества №1. Отключения дата-центров для того, чтобы остановить катастрофу, теперь уже недостаточно. Юдковский отмечает, что уже в ближайшее время будет создан сверхразум, который будет в миллионы раз умнее людей и будет долго существовать внутри компьютеров. Остаётся лишь одно средство против такого врага — авиационные бомбардировки. Иначе будет поздно.

Человек с точки зрения рационализма несовершенен. Между самими людьми из-за этого возникают проблемы. Что уже говорить об исскуственном интелекте, который будет всё оценивать на абсолютный рационализм и абсолютное совершенство...

![[Последнее «прости»] Остановите масштабные эксперименты с искусственным интеллектом! Раскрыто содержание письма Маска и Возняка с призывом приостановить обучение нейросетей](/story_images/660000/1680345751_65_1680345365_38_1680345221_80_1680345142_56_1680344991_53_1680344522_27_249707853_0:163:1920:1123_1280x0_80_0_0_126a5dcd4108ae4d05371ef1fca0df4b.jpg.webp)